还记得那个功能逆天的“文生视频”和“视频生视频”的Gen-2吗?上周末有一位网友@Nick St. Pierre 非常幸运地获得了Gen-2应用的内测资格。

“顺便说一句,Gen-1实际上不是文本到视频,而是视频到视频;Gen-2是实际的文本到视频,您甚至不需要参考视频。”Nick这样定义Gen-2的功能进化,它不单单是1.0到2.0的版本升级,而是一个大换血式的功能迭代。

首先,Nick给Gen-2发布了一个文本提示:

一个对称的人在酒吧接受采访 --interpolate --upscale --cfg_scale 7.5 #gen2

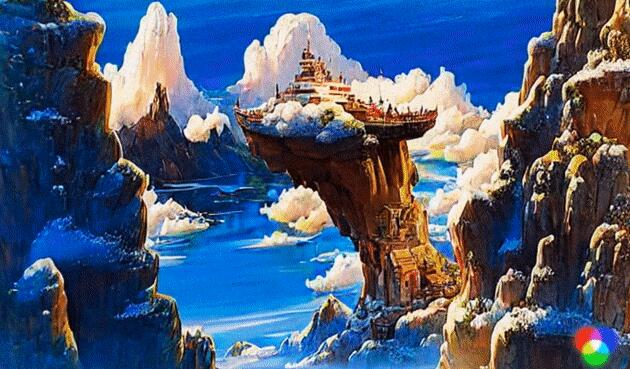

这有点像操作视频版的“Midjourney”,它通过文本提示生成的视频效果如下:

同一段提示词还生成了下面这个视频效果:

Nick评价道:我试图从Gen-2中获得一些半现实的东西,目前的它,还不能真正理解相机的移动/位置。现在的它只是一个婴儿,但它一定会变得更好。

Nick是在4月7日开始陆续发布Gen-2测试视频的,网友们是在4月8日开始炸的:

Gen-2是Runway公司在今年3月份推出的一个应用新版本,星仔曾在《5款设计师必须会用的AI辅助工具》一文中提到过。在Gen-2中,你能用任意的图像、视频或文本来生成一段电影。尤其是可以只凭借文本提示,在没有参考视频的前提下,也能够生成各种不同风格的视频,科幻、朋克、动画、3D……无所不能!

而除了文生视频、图生视频、文+图生视频,Gen-2还可以实现视频风格化(比如将普通拍摄变成好莱坞特效风格)、修改视频中物体的形态(比如几秒钟将视频中的金毛变成斑点狗)等等功能。就连多年从事影视行业的老司机,都得说上一句“丧心病狂”……

这次拿到内测资格的Nick,还公开了他做的另外一版测试:

我想使用文字转视频制作一部科幻电影预告片,回复一个描述你想看什么的句子,我会让他们通过Gen-2并用视频回应。这是“一个穿着黄色宇航服的人浑身是黏液”,实测效果如下:

不光如此,Nick还越玩越high了。这不,他又把自己前几天做的外星人导入到酒吧男人的场景里,怎么说呢,看起来也不是很违和的样子。

目前,Gen-1已经面向公众开放,普通用户有125次使用机会,之后可像Midjourney一样按月付费使用。目前,Gen-2还没有正式对公开放,你是希望它早点开放呢,还是早点开放呢?

版权声明 | 文章整理自网络,仅供学习参考,版权归属原作所有

如有问题,请及时与我们联系,我们将第一时间做出处理